"L’IA générative n’est pas un simple outil neutre d’aide.

Sans cadre juridique clair, sans traçabilité et sans distinction des usages,

le risque principal est le transfert silencieux de responsabilité vers le professionnel"

Et c'est exactement ce que l'infographie un peu catastrophique distribuée par la HAS ne montre pas .....

L'arrivée de l’intelligence artificielle générative suscite un intérêt croissant dans les secteurs sanitaire, social et médico-social pour leurs capacités d’assistance rédactionnelle, d’aide à la synthèse ou de soutien à la réflexion professionnelle voir même aux décisions thérapeutiques.

La Haute Autorité de Santé (HAS) a donc publié un document visant à proposer des premières clés d’usage afin d’accompagner les professionnels dans une utilisation jugée responsable de ces technologies émergentes.

Mais l’intégration de l’IA générative en santé soulève des enjeux spécifiques qui dépassent largement les cadres habituels des évaluations de l'HAS:

- incertitude intrinsèque des contenus produits (5)

- absence de traçabilité scientifique directe (2),

- non-déterminisme des réponses (2)

- opacité partielle des modèles (5)

- responsabilité juridique diffuse. (4)

Ces caractéristiques interrogent la pertinence des recommandations proposées, leur applicabilité opérationnelle et leur capacité à répondre aux risques réels associés à ces technologies.

J'ai tenté une analyse critique du document de la HAS pour voir si c'est cohérent, la faisabilité pratique et la solidité normative des principes énoncés, au regard du fonctionnement interne des systèmes d’IA générative et des demandes pratiques des professionnels en santé.

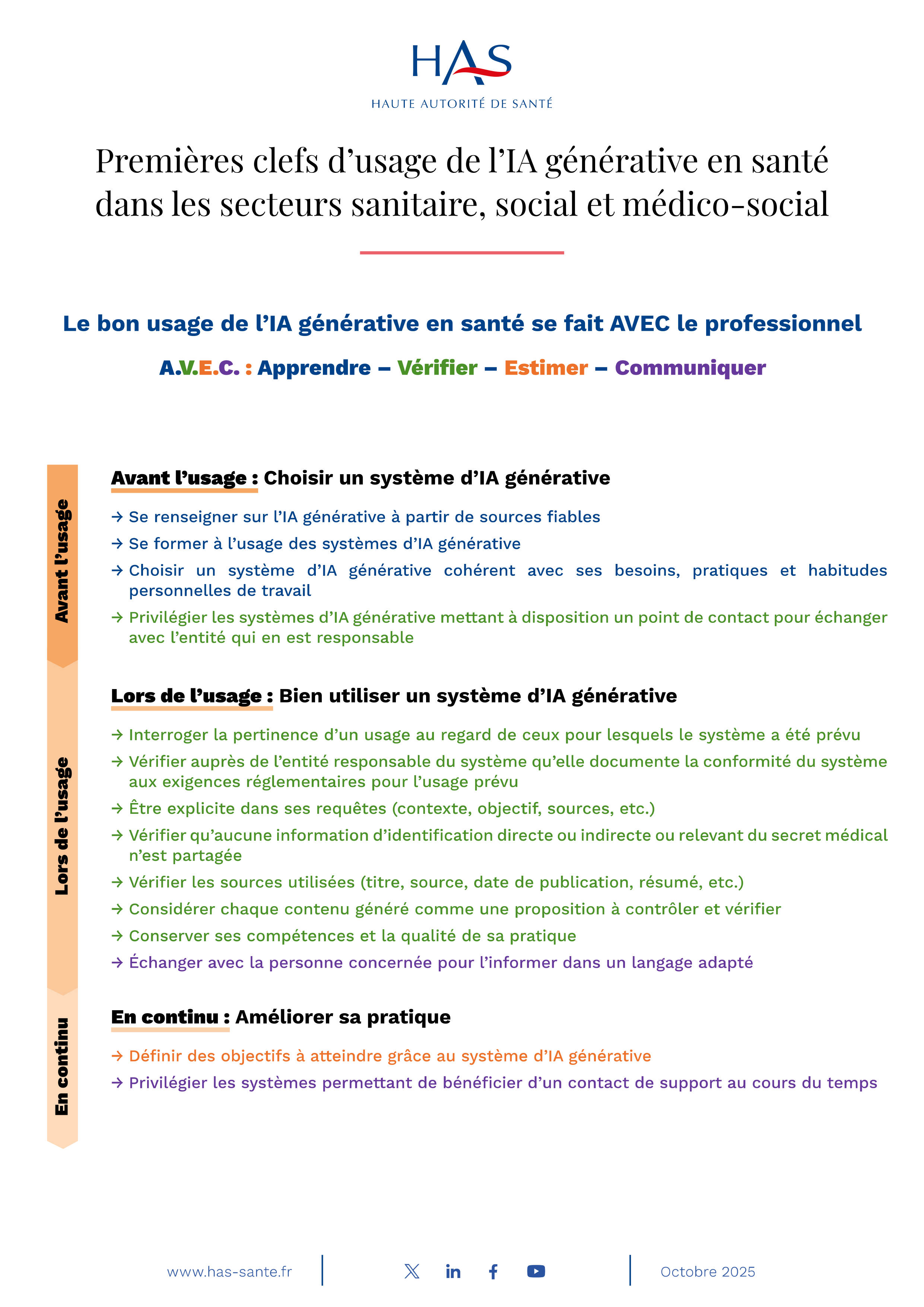

Analysons point par point cette infogaphie de la HAS:

Je cite:

Premières clefs d'usage de l'IA générative en santédans les secteurs sanitaire, social et médico-social

Problème :

- Le terme « clefs d’usage » est flou : il ne précise pas s’il s’agit de recommandations, de bonnes pratiques, d’orientations non opposables ou d’un cadre normatif.

- Le périmètre annoncé (sanitaire, social, médico-social) est très large, alors que les contraintes réglementaires et les risques diffèrent fortement entre ces secteurs !!! (bah oui, entre rechercher des activités sociales pour des personnes à mobilité réduite (ex médico social) à une proposition de prise en charge médicale d'un patient atteint d'une maladie orpheline, on voit bien qu'il existe des risques légaux et éthiques augmentant quand on passe le curseur de l'IA du social au médical pur.)

Le bon usage de L’IA générative en santé se fait AVEC Le professionnel

Problème :

- Formulation normative implicite sans base juridique explicite.

- Elle suggère que la présence ou l’implication du professionnel suffirait à sécuriser l’usage, ce qui est inexact du point de vue réglementaire et médico-légal (on va y revenir plus tard).

Avant l'usage : Choisir un système d’IA générative

> Se renseigner sur l'IA générative à partir de sources fiables

Problème :

- Notion de « sources fiables » non définie car en pratique, les informations fiables sur les LLM (données d’entraînement, limites, biais) sont rarement accessibles publiquement. (et pour cause: les IA sont trop seouvent entrainées sur des données littéraires piratées (6)) et donc les sources fiables de l'IA génératives ne sont en fait.... pas très fiables !

- Recommandation générique, non spécifique à l’IA générative.

> Se former à l’usage des systèmes d’IA générative

Problème :

- Aucun niveau de formation, contenu minimal ou référentiel n’est précisé.

- Ne distingue pas formation technique, éthique, juridique ou clinique.

- Risque de devenir une injonction sans moyen.

> Choisir un système d’IA générative cohérent avec ses besoins, pratiques et habitudes

personnelles de travail

Problème :

- Critère centré sur le confort et les habitudes personnelles, pas sur la sécurité, la conformité ou l’impact sur les patients.

- Ne tient pas compte des obligations institutionnelles ou réglementaires.

- Confusion entre outil personnel et outil professionnel.

> Privilégier Les systèmes d’IA générative mettant à disposition un point de contact pour échanger

avec l'entité qui en est responsable

Problème :

- Un “point de contact” ne garantit ni transparence, ni conformité, ni responsabilité (le truc le plus amusant: le point de contact est souvent la même IA qui vous répond !!!)

- Critère faible présenté comme élément de confiance.

- Ne précise pas la nature du contact (support technique, juridique, commercial).

> Lors de l'usage : Bien utiliser un système d’IA générative

Problème :

- Les usages “prévus” ne sont généralement pas définis clairement pour les LLM généralistes !.

- Le professionnel n’a souvent aucun moyen de connaître les limites d’usage réelles ! (Vous ne verrez jamais par exemple des avertissements de ce type pour un LLM: "ce LLM est particulièrement doué pour la résolution des problèmes géométriques mais est particulièrement nulle en cuisine Coréenne.").

- Responsabilité transférée à l’utilisateur sans information suffisante.

> Interroger la pertinence d’un usage au regard de ceux pour lesquels le système a été prévu

Problème majeur :

- Vérification juridiquement irréaliste pour un professionnel de santé.

- La conformité (RGPD, HDS, MDR) relève de l’éditeur et de l’établissement, pas de l’utilisateur final.

- Risque de responsabilité indue en cas de contentieux.

- la quasi majorité de LLM se veulent être généralistes et il y a peu de LLM spécialisés dans un sujet actuellement

> Vérifier auprès de l'entité responsable du système qu'elle documente la conformité du système aux exigences réglementaires pour l'usage prévu

Problème majeur :

- Vérification juridiquement irréaliste pour un professionnel de santé.

- La conformité (RGPD, HDS, MDR) relève de l’éditeur et de l’établissement, pas de l’utilisateur final.

- Risque de responsabilité indue en cas de contentieux.

> Être explicite dans ses requêtes (contexte, objectif, sources, etc.)

Problème :

- Conseil d’usage valide mais trivial.

- Ne traite pas les risques induits par une requête bien formulée mais juridiquement ou éthiquement problématique.

- Absence de garde-fous sur le contenu des requêtes.

> Vérifier qu'aucune information d'identification directe ou indirecte ou relevant du secret médical n'est partagée

Problème :

- Recommandation essentielle mais insuffisante.

- Ne traite pas :

- les identifiants indirects complexes,

- la ré-identification,

- la mémorisation des données par le système.

- Donne l’impression que l’anonymisation manuelle suffit.

NB: La ré-indentification en santé est toujours possible (ex: la fameuse devinette: "Qu'est-ce qui a 4 pattes, une queue, qui abboie et qui est le meilleur ami de l'homme ?") même si les données sont anonymisées.

- La notion d’« identification indirecte » est extrêmement large en santé.

- Une simple combinaison :

- âge + pathologie + contexte

suffit souvent à réidentifier.

- âge + pathologie + contexte

Le document :

- ne fournit aucun seuil,

- aucune méthode d’anonymisation,

- aucun exemple concret.

Responsabilité transférée sans moyens.

> Vérifier Les sources utilisées (titre, source, date de publication, résumé, etc.)

Problème :

- Les modèles génératifs n’indiquent pas toujours leurs sources réelles. (6)

- Vérification souvent impossible ou illusoire.

- Recommandation déconnectée des capacités techniques des LLM.

> Considérer chaque contenu généré comme une proposition à contrôler et vérifier

Problème :

- Principe sain mais insuffisant.

- Ne précise pas comment contrôler, avec quels outils, ni avec quels critères.

- Sous-estime l’effet d’autorité cognitive de l’IA. (biais d'autorité de l'IA sur l'utilisateur qui est un peu soumis à l'outil en pensant qu'il ne pourra pas faire mieux)

> Conserver ses compétences et La qualité de sa pratique

Problème :

- Formulation morale, non opérationnelle.

- Aucun indicateur mesurable.

- Sert davantage de clause de style que de recommandation exploitable.

« Conserver ses compétences » : aveu implicite de danger d'usage de l'IA par les professionnels de la part de la HAS

Lecture critique

Cette phrase reconnaît implicitement que :

- l’outil peut appauvrir la compétence,

- l’outil peut dégrader la pratique,

- l’outil peut induire une dépendance cognitive.

Mais :

- aucune mesure de prévention,

- aucun indicateur de dégradation,

- aucun mécanisme de contrôle.

= Avertissement sans protection.

> Échanger avec la personne concernée pour l’informer dans un langage adapté.

Problème :

- Ne précise pas :

- le niveau d’information requis,

- le consentement,

- la traçabilité de cet échange.

- Silence sur les implications médico-légales.

En continu: améliorer sa pratique

Problème :

- Ne distingue pas objectifs cliniques, organisationnels ou personnels.

- Aucun cadre d’évaluation des risques associés à ces objectifs.

> Définir des objectifs à atteindre grâce au système d’IA générative

Problème :

- Répétition d’un critère déjà cité.

- Le support n’est pas un gage de conformité, de sécurité ou de responsabilité.

- Critère faible surreprésenté.

> Privilégier les systèmes permettant de bénéficier d’un contact de support au cours du temps

Problème :

- Un “point de contact” ne garantit ni transparence, ni conformité, ni responsabilité.

- Critère faible présenté comme élément de confiance.

- Ne précise pas la nature du contact (support technique, juridique, commercial).

Lors de l'usage : Bien utiliser un système d’IA générative

« Interroger la pertinence d’un usage au regard de ceux pour lesquels le système a été prévu »

Problème :

- Les usages “prévus” ne sont généralement pas définis clairement pour les LLM généralistes.

- Le professionnel n’a souvent aucun moyen de connaître les limites d’usage réelles.

- Responsabilité transférée à l’utilisateur sans information suffisante.

Conclusion factuelle

Le texte multiplie des recommandations générales, souvent consensuelles, mais :

- transfère une responsabilité excessive au professionnel,

- repose sur des vérifications irréalisables,

- omet des enjeux majeurs (biais, traçabilité, responsabilité),

- et donne une impression de cadrage sans fournir de cadre réellement opérant.

Ce que le professionnel ne peut pas vérifier

La conformité réelle des systèmes

- Un professionnel de santé ne peut pas auditer :

- la conformité RGPD,

- l’hébergement des données,

- la conformité MDR,

- ni les conditions d’entraînement d’un LLM.

- Ces éléments relèvent de l’éditeur, de l’établissement et des contrats, pas de l’utilisateur final.

Les sources réelles des réponses

- Les IA génératives ne citent pas leurs sources réelles.

- Une référence plausible peut être :

- inexistante,

- mal attribuée,

- ou partiellement inventée.

2. Les risques cognitifs ignorés

Effet d’autorité de la machine

- Une réponse bien formulée peut :

- réduire l’esprit critique,

- influencer une décision clinique,

- même si elle est incorrecte.

Biais algorithmiques

- Biais statistiques, culturels et linguistiques intégrés au modèle.

- Absence de garantie de neutralité médicale ou scientifique.

Hallucinations

- Une IA peut produire :

- des faits faux de manière tacite (avec un aprrentissage sur des documents faux ou biaisés) ou involontaire: hallucination.

- des recommandations inexistantes,

- sans signaler explicitement l’erreur.

3. Les angles morts juridiques

Responsabilité médico-légale

- En cas d’erreur ou de préjudice :

- la responsabilité repose quasi exclusivement sur le professionnel.

- Aucune clarification sur :

- la responsabilité partagée,

- la couverture assurantielle,

- la traçabilité probatoire.

Traçabilité absente

- Rien n’est dit sur :

- la conservation des requêtes,

- la journalisation des usages,

- la preuve de ce qui a été utilisé ou non.

4. Ce que “bon usage” ne garantit pas

Le “bon usage” n’est pas une protection juridique

- Respecter des recommandations générales :

- ne vaut pas conformité réglementaire,

- ne protège pas en cas de contentieux.

La présence humaine ne neutralise pas le risque

- Le fait qu’un professionnel soit “dans la boucle” :

- n’annule pas les biais,

- n’élimine pas les erreurs,

- ne transforme pas un outil non certifié en outil sûr.

5. Les confusions entretenues

IA unique vs réalités multiples

- Aucune distinction entre :

- IA grand public,

- IA locale,

- IA certifiée,

- aide à la rédaction vs aide à la décision.

- Or les obligations et les risques sont radicalement différents.

Outil personnel vs outil professionnel

- Utiliser une IA “adaptée à ses habitudes” peut être :

- incompatible avec les règles institutionnelles,

- contraire aux exigences de protection des données.

6. Ce qui manque pour un cadre réellement protecteur

- Des cas d’usage explicitement autorisés / interdits

- Des exemples concrets d’erreurs et de dérives

- Un cadre clair de responsabilité

- Des exigences minimales de traçabilité

- Une distinction nette entre information, assistance et décision

"L’IA générative n’est pas un simple outil neutre d’aide.

Sans cadre juridique clair, sans traçabilité et sans distinction des usages,

le risque principal est le transfert silencieux de responsabilité vers le professionnel."

Conclusion:

Le document de la Haute Autorité de Santé constitue une première tentative de cadrage dans un domaine encore en construction, marqué par une évolution technologique rapide et une incertitude réglementaire persistante.

Il a le mérite de sensibiliser les professionnels aux enjeux éthiques, organisationnels et informationnels liés à l’usage de l’IA générative, et de rappeler la nécessité d’un regard critique sur les contenus produits.

Néanmoins, l’analyse de la HAS met en évidence un décalage entre les principes généraux énoncés et les contraintes techniques, juridiques et épistémologiques propres aux systèmes d’IA générative.

Les recommandations proposées reposent largement sur la vigilance individuelle des professionnels, sans toujours fournir les moyens opérationnels, méthodologiques ou institutionnels permettant de garantir leur mise en œuvre effective.

Dans cette perspective, ce document peut être considéré comme une base de réflexion plutôt que comme un cadre d’usage stabilisé.

Son apport gagnerait à être complété par des clarifications sur les responsabilités, des critères d’évaluation plus précis, ainsi que par une distinction plus nette entre les usages informationnels, organisationnels et cliniques de l’IA générative.

Une telle évolution permettrait de mieux aligner les recommandations avec la réalité des pratiques et les exigences de sécurité propres au champ de la santé et de mieux protéger juridiquement les utilisateurs de l'IA.

Absence totale de ce qui est pourtant central

Le document ne traite PAS :

- des hallucinations factuelles,

- de la non-reproductibilité des réponses,

- des biais culturels et médicaux,

- de la dérive d’usage (off-label),

- de la responsabilité pénale en cas de dommage,

- de la traçabilité des décisions,

- de l’explicabilité réelle (pas marketing).

Ce sont pourtant les problèmes majeurs.

Conclusion synthétique

Ce document :

- n’est pas faux,

- mais n’est pas opérant.

Il :

- déplace la responsabilité vers l’utilisateur,

- applique un cadre réglementaire inadapté,

- transforme des impossibilités techniques en obligations morales,

- remplace des règles par des slogans,

- et donne une illusion de sécurité là où il n’y en a pas.

C’est un document de communication institutionnelle, pas un cadre d’usage robuste.

SOURCES:

(1) Source de l'infographie de la HAS:

https://www.has-sante.fr/jcms/p_3703123/fr/a-v-e-c-infographie

Vu dans 'ensemble de documents ici:

https://www.has-sante.fr/jcms/p_3703115/fr/premieres-clefs-d-usage-de-l-ia-generative-en-sante#ancreDocAss

(2) le non-déterminisme en IA:

.../...Le non-déterminisme dans les grands modèles de langage est un concept en apparence simple mais dont les implications sont majeures. Lorsque vous fournissez exactement la même requête à un LLM plusieurs fois, vous obtenez des réponses différentes parfois légèrement différentes, parfois radicalement. Cette incohérence va à l’encontre d’un des principes fondamentaux de la méthode scientifique : la reproductibilité. .../...

Source: https://www.flowhunt.io/fr/blog/defeating-non-determinism-in-llms/#

(3)

(4) La notion de responsabilité n'est pas encore vraiment tranchée: qui est fautif en cas de soucis: L'utilisateur ? l'IA ? celui qui a créé/propose l'IA ?

.../...En tout état de cause, le droit semble devoir s’adapter aux systèmes d’intelligence artificielle et, pour ce faire, pouvoir s’inspirer d’autres domaines présentant des enjeux similaires. Ainsi, il est souhaité de passer d’un droit de réaction à un droit d’anticipation. L’enjeu majeur est celui de l’effectivité du droit adopté, de sa bonne application et de son caractère réparateur en cas de préjudice. Cela pose notamment la question de la responsabilité en cas de dommage lié au fonctionnement d’un système d’intelligence artificielle, interrogation d’actualité et encore en débat.

(5) La nouvelle directive n° 2024/2853, publiée au JOUE le 18 novembre 2024, est sur le point de faire entrer le régime de la responsabilité des produits défectueux dans une nouvelle ère.

.../...Les comportements inattendus, nouvelle catégorie juridique propre à l’IA, qui renvoie au problème d’alignement bien connu en sciences informatiques : le décalage entre les objectifs assignés et ceux réellement optimisés par le système. Il en résulte qu’un système d’IA sera juridiquement qualifié de défectueux dès lors que son algorithme d’apprentissage autonome lui permet d’évoluer, sans intervention humaine, vers une configuration susceptible de générer un comportement techniquement cohérent, mais dangereux, révélant une absence de maîtrise suffisante de son évolution par le fabricant. .../...

.../...

.../...La présomption à raison d’une difficulté excessive. En raison de l’opacité fonctionnelle des réseaux neuronaux, la directive a introduit une véritable innovation (art. 10, § 4) pour les produits numériques dont la complexité technique ou scientifique rend la preuve excessivement difficile. Ce mécanisme probatoire est conditionné au fait que :

- 1. le demandeur démontre des difficultés excessives liées à la complexité technique ou scientifique pour établir le défaut ou la causalité, malgré les éléments reçus ;

- 2. il établit seulement la probabilité simple et non « élevée » du défaut ou du lien causal.

Dès lors, le juge présume soit la défectuosité, soit la causalité, soit les deux. Concrètement, confrontée à un réseau de neurones non interprétable (black box), la victime d’un diagnostic médical erroné pourra invoquer l’opacité de l’algorithme. Le fabricant pourra dans un premier temps contester l’existence des difficultés excessives de prouver le défaut ou le lien de causalité. En cas d’échec, le fabricant devra alors démontrer l’absence de défaut ou de lien de causalité. Cette bascule traduit l’idée qu’au-delà d’un certain degré d’opacité algorithmique, exiger une preuve classique revient à priver la victime de toute action. .../...